¿Has oído hablar muchas veces del archivo robots.txt pero aún no sabes de qué se trata exactamente ni qué utilidad tiene dentro de un proyecto Web?

A menudo, dentro del mundo del marketing digital y el SEO se habla sobre cómo conseguir backlinks, cómo mejorar el CTR, cuál es la mejor manera de gestionar las plataformas sociales, etc.

Sin embargo, y pese a que estos aspectos son muy importantes dentro de un plan de marketing, hay ocasiones en que se pasan por alto otros pilares fundamentales del ámbito digital.

Algunos de ellos son el rastreo y la indexación de páginas en Internet.

Por este motivo, hoy te hablaré sobre el archivo robots.txt, uno de los métodos más usados y a la vez aceptados por Google para poder indexar tus contenidos.

Dicho archivo, junto al Sitemap XML, que también hay que optimizarlo para WordPress, son los principales medios de los que dispondrás para controlar el movimiento de los bots de Google dentro de tu página.

Por este motivo, en el post de hoy te voy a contar qué es concretamente este fichero, comprenderás para qué sirve y cómo puedes crear uno para tu sitio Web.

¿Qué es el archivo robots.txt?

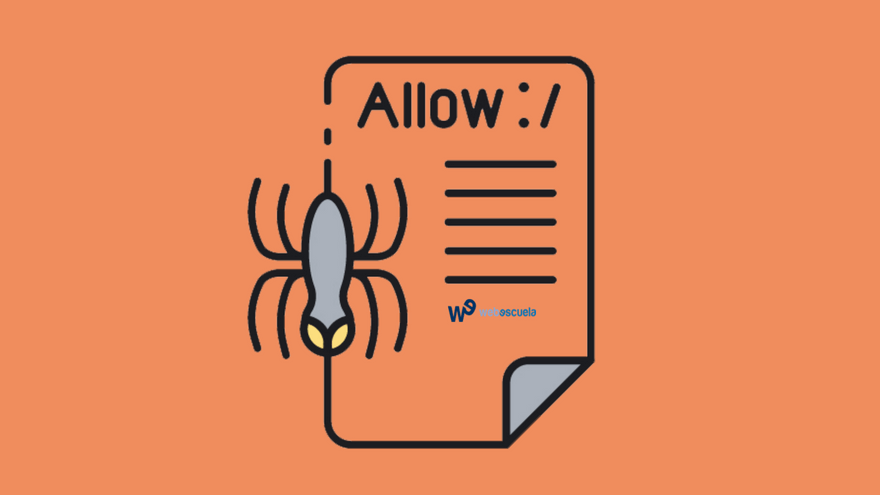

El fichero robots.txt es un archivo de texto, que ofrece unas recomendaciones de indexación a los crawlers de búsqueda de Google y otros buscadores en Internet.

Del mismo modo, también ofrecen indicaciones sobre el comportamiento que éstos deben tener al llegar a algunas de las URL’s de nuestro sitio.

Y es que, los rastreadores, las arañas o los bots de Google (según los quieras llamar) son avariciosos por naturaleza. Es decir, cada vez que el buscador detecta que hay una nueva página en Internet, manda a sus arañas a rastrear todo el «site».

En este proceso, las arañas o bots se encargan de rebuscar entre todos los archivos de tu página, siempre y cuando no se lo impidas.

Para controlar estos bots o arañas de Google tendrás que utilizar este tipo de fichero.

Mediante este archivo, podrás indicar a Google qué partes de tu página quieres que no sean rastreadas por estos bots.

Por tanto, es fácil adivinar que la mejorará, en cierta manera, la experiencia de usuario que tendrá el buscador en tu «site».

El robots.txt da recomendaciones, pero no órdenes

Dicho de otro modo, este archivo se encargará de cortar el paso a estas arañas, para ocultar “a ojos de Google” ciertas partes de tu sitio.

De todos modos, y tal y como se ha comprobado en numerosos experimentos de optimización del Posicionamiento SEO, las directrices existentes en un fichero como éste son una indicación para Google, pero nunca una norma.

Es decir, aunque hayas «capado» el acceso a una determinada zona de tu página Web mediante este fichero, puede que el bot de Google la rastree igualmente, aunque luego no añada dicha página a su índice.

Entonces te preguntarás ¿Para qué sirve entonces este archivo?

Te lo explico continuación…

¿Para qué sirve el archivo robots.txt?

Cualquier bot o araña (ya sea de Google, Bing, Yandex, etc.), lo primero que hace antes de comenzar a rastrear una página es localizar y ver el archivo, para saber qué partes son accesibles y cuáles no.

Esto es muy importante ya que de esta manera estarás guiando al bot por toda tu Web mediante una serie de indicaciones.

De esta manera, estarás proporcionando una información muy valiosa al bot que mejorará su crawleo y, por lo tanto, tu mejorarás tu crawl budget.

Es muy probable que en un site normal, el número de URL’s no supere las 1000. Sin embargo, en una tienda online, lo normal es que cuentes con más de 5000 URL’s, entre categorías, productos, paginaciones, parámetros, etc.

Por este motivo, este fichero digital es fundamental para priorizar qué zonas de tu Web quieres que rastree el bot sí o sí y cuáles pueden ser secundarias.

Además, ten en cuenta que en el propio fichero indicarás al bot la URL donde podrá encontrar el Sitemap de tu sitio. Por lo tanto, en este archivo la araña tendrá todo lo necesario para comenzar a rastrear tu Web.

Como has visto, este archivo es fundamental para que el bot no pierda el tiempo en secciones irrelevantes o prohibidas a ojos del usuario.

Por lo tanto, el este fichero será, junto al Sitemap XML, el primer punto de partida para la optimización de tu proyecto Online.

Ejemplos de ficheros «Robots.txt»

En Internet existen decenas y decenas de ejemplos, tanto para WordPress, para Prestashop, etc., y así como para cualquier CMS en el que diseñes tu proyecto digital.

Sin embargo, bajo mi punto de vista, en la mayoría de casos este proceso no es el correcto, ya que salvo que tengas el típico blog en WordPress.com, cada Web es única e irrepetible.

Por este motivo, proporcionarte uno para copiar y pegar en tu sitio no será la mejor opción para tu proyecto online. Lo mejor en este caso será crear tu propio archivo en base a lo que haga tu competencia.

Para conocer cuál es el de tu competencia y estudiar como lo hacen los mejores simplemente tendrás que escribir su URL en el navegador e indicar su ruta, que generalmente es:

/robots.txt

Por lo tanto, para conocer el de cualquier dominio en Internet tendrás que introducir la siguiente URL en tu navegador:

https://dominioaestudiar.com/robots.txt

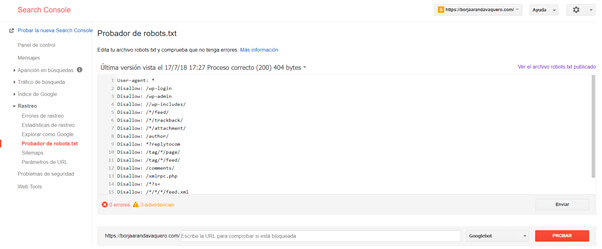

De todos modos, y gracias a la herramienta «Google Search Console», podrás probar los tuyos propios antes de subirlos a tu página y que, de esta manera, no bloquees secciones que no quieras.

Para acceder a esta sección simplemente tendrás que ir a tu Search Console y acceder a la sección “Probador de robots.txt” dentro de la sección “Rastreo”.

En esta sección, podrás escribir tu propio archivo y posteriormente probarlo en una URL en concreto, para checkear que todo esté correcto y que el bot puede o no acceder a esa URL (según le hayas indicado).

Esta herramienta es especialmente útil para aprender los distintos códigos de este archivo, sobretodo si eres novato en este aspecto.

¿Cómo puedo crear mi propio archivo «Robots.txt»?

Antes de nada, he de avisarte que un fichero de este tipo no es obligatorio/necesario, salvo que quieras restringir al acceso de los bots a ciertas zonas de tu dominio.

Por lo tanto, si tu sitio es muy pequeño y te da igual hasta dónde quieres que llegue la araña de Google, no necesitarás subir este archivo subido a tu servidor.

1. Crea un bloc de notas con este nombre

Si una vez dicho esto, quieres seguir adelante con la idea de crear un archivo robots.txt para tu propio proyecto Online, tendrás que abrir un bloc de notas.

Seguidamente, guárdalo con el nombre de: “robots.txt”.

2. Súbelo a tu hosting

Posteriormente, súbelo a la carpeta raíz de tu dominio (vía FTP o plugin).

Debes de tener en cuenta que todo fichero cumple una serie de normas o protocolo para que todo bot pueda interpretar las directrices de este.

Estas normas son:

- Solo se aceptarán caracteres permitidos.

- Se hacen diferencias entre mayúsculas, minúsculas, puntuaciones y espacios.

- Cada User-agent y Disallow deberá de estar separado por una línea totalmente en blanco.

- Los comentarios los podrás introducir mediante una almohadilla (#).

Una vez creado el archivo ya podrás editarlo y comenzar a escribir las directrices en él.

Comandos principales de este archivo

Los comandos que podrás utilizar son:

- User-agent. Indica qué tipo de robot debe cumplir con las directivas que se indican a continuación.

- Disallow. Deniega el acceso a un directorio o página concreta.

- Allow. Permite el acceso a un directorio y página en conreto.

- Sitemap. Indica la ruta donde se encuentra tu mapa del sitio en XML.

- Crawl-delay. Indica al robot el número de segundos que debe esperar entre el rastreo de cada página.

- Asterisco (*). Vale por una secuencia cualquiera de caracteres. Por ejemplo, todos los directorios que empiezan por “norastrear” serían “/norastrear*/”

- Dólar ($). Indica el final de una URL. Es decir, sirve para indicar cualquier archivo que acabe con la extensión «.php». En este caso sería “/*.php$”.

¿Cómo subir tu archivo robots.txt en WordPress y en PrestaShop?

Para subir un fichero como el que hoy nos ocupa a tu página tienes dos opciones:

- Hacerlo vía FTP. Con el gestor FTP interno de tu servidor o un programa FTP como Filezilla.

- Subirlo mediante plugins o extensiones de tu CMS.

► Mediante el FTP Filezilla

Para realizar este método, simplemente tendrás que descargarte el programa Filezilla y crear un nuevo proyecto con los datos que te proporcionará tu hosting.

Una vez creado el proyecto, simplemente tendrás que conectarte a tu directorio raíz y arrastrar tu fichero, hasta ese directorio raíz para subirlo a tu hosting.

Con este sencillo proceso ya tendrás disponibles las directrices para los bots. Si no sabes cómo manejar el programa Filezilla mira este tutorial:

► Subir el archivo Robots.txt con WordPress

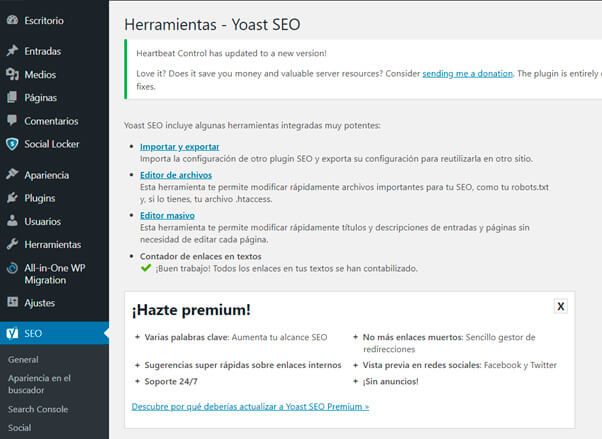

Para este cometido, en el caso de que utilices el plugin de «SEO Yoast», tendrás que acceder a la sección “Herramientas” y luego hacer clic en “Editor de archivos”.

De esta manera, podrás cambiar tu archivo sin necesidad de hacerlo vía FTP.

En el caso de que esta solución no te convenza, siempre podrás instalar un plugin de WordPress específico para este cometido, como WP Robots Txt (ver aquí).

► Crear archivo Robots.txt con PrestaShop

Podrás generar un fichero de este tipo en PrestaShop directamente desde el panel de control.

Para ello, tendrás que acceder a:

- Preferencias > SEO y URLs > Generación de archivos Robots

De hecho, existe una función en PrestaShop que se encargará de generar uno de forma automática.

De todos modos, y como te he indicado anteriormente, te recomiendo que revises este archivo por defecto, ya que cada cada sitio Web es un mundo.

Conclusiones

Cómo has visto a lo largo del post, crear un archivo robots.txt es fundamental para controlar la indexación y el rastreo de los bots de Google.

Por este motivo, es fundamental que desarrolles tu propio archivo a medida y no utilices los creados por defecto, que tanto abundan por Internet.

En el caso de que tu página sea un eCommerce, este archivo cobrará especial importancia, ya que con él podrás optimizar el crawleo lo máximo posible.

Eso hará que Google mejore tu posicionamiento orgánico, junto a sus factores relevantes, como son el aumento del CTR o el SEO On-Page, entre otros.

Por lo tanto, pierde un poco de tiempo en optimizar este archivo y tu posicionamiento SEO mejorará.

Tras comprender qué es el robots.txt, ¿qué otras formas de crearlo y configurarlo te funcionan?

Imágenes (Free virtual) de Shutterstock.

Cuéntanos en los comentarios qué opinas sobre este fichero digital.

También te puede interesar:

No hay Comentarios